-

L’une des grandes différences entre la langue chinoise et la langue française est que le français a une espace entre deux mots, alors que le chinois n’en a pas. En conséquence, avant de traiter les corpus, il faut que l’on ajoute les espaces entre les mots chinois.

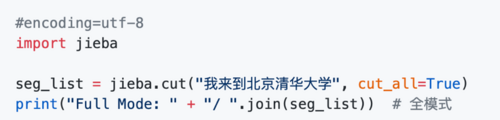

1. Outil : jieba

On utilise le module jieba développé par MIT, qui est un outil de la segmentation des mots basé sur le langage Python. En plus, pour les mots inconnus, un modèle basé sur HMM est utilisé avec l'algorithme de Viterbi. Ce qui m’intéresse beaucoup est qu’il nous permet d’ajouter les dictionnaires personnalisés.

D’ailleurs, son installation est assez facile.

Pour l’utilisation de jieba, juste importe jieba dans le script Python.

Voici le résultat :

2. Traitement de corpus

Avec l’aide jieba, on peut modifier les phrases chinois comme ci-dessous en ajoutant une espace entre les mots chinois.

Par exemple, dans l’un de mes corpus, on a un texte qui décrit la manifestation en Chine.

Après le traitement de jieba, on a des résultats comme ci-dessous :

On pourrait voir que le résultat est assez satisfaisant et valable.

Normalement, un mot chinois a un ou deux caractères, par example, le mot « 中国(la Chine) » a deux caractères, et « 有(avoir) » est un caractères. Mais, dans notre corpus, le mot chinois « 示威游行» que l’on a choisi pour le mot français « la manifestation » a quatre caractères, donc, il est mieux que l’on l’ajoute dans les dictionnaires personnalisés de jieba.

Pour ajouter un mot dans notre dictionnaire, il nous faut créer un fichier.txt qui contient les mots, ce qui nous permet d’une plus grande précision.

Donc, on ajoute le mot chinois dans le fichier, ligne par ligne. Et dans le script Python, on utilise jieba.load_userdict(file_name) pour appeler le fichier.

La prochaine fois, on va voir comment on met le script Python dans notre script.sh et on espère qu'on pourra bien réussir à notre projet.

下回分解

Mei, Anaëlle et Chinastu

votre commentaire

votre commentaire

-

Nous avons rencontré un problème pour récupérer des URLs "en anglais".

La dernière fois, nous avions récupéré des URLs de sites internets de toutes les langues que nous avons choisi, en utilisant un algorithme. Cependant dans la liste des URLs anglaises, nous n'avons trouvé presque que des URLs en français.

Nous supposons que le problèmes est le mot "demonstration" qui serait considéré comme un mot français par le PC. Par conséquent, nous avons reçu des URls qui sont pour la plupart en anglais et peu en français...

Pour l'instant, nous avons récupéré des URLs anglaises manuellement pour avancer, mais nous allons réfléchir à une meilleure solution !下回分解!

Chinatsu, Mei et Anaëlle.

votre commentaire

votre commentaire

français, anglais, japonais et mandarin